AI Formula

基本概念

- 损失函数

- 梯度下降算法

- 深度学习中的激活函数

MLP(多层感知机,Multi-LayerPerceptron)神经网络CNN卷积神经网络- 图片(

RGB和灰度图)

数据处理

数据无量纲化

https://github.com/fengdu78/Coursera-ML-AndrewNg-Notes

- Prompt optimization

损失函数

- 回归任务的损失函数(用于预测连续值)

- 分类任务的损失函数(用于预测离散类别)

- 目标检测/分割任务的损失函数

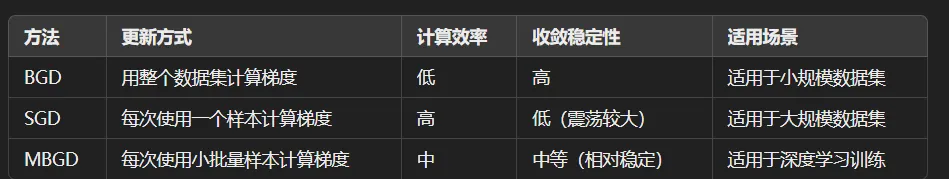

梯度下降算法

激活函数

MLP 原理

线性变化

其中:

- 是权重矩阵,

- 是输入向量,

- 是偏置项(bias)。

激活函数

SoftMax 省略,转化数据为概率分布

反向传播

其中α 是学习率

CNN 原理

包括四层

- 卷积层

- 池化层

- 全连接层

- 输出层

其它神经网络

- 循环神经网络(RNN, Recurrent Neural Network)

- 长短时记忆网络(LSTM, Long Short-Term Memory)

- 门控循环单元(GRU, Gated Recurrent Unit)

- 自编码器(Autoencoder)

- 生成对抗网络(GAN, Generative Adversarial Network)

- Transformer 网络

- 图神经网络(GNN, Graph Neural Network)

- 强化学习网络(Reinforcement Learning, RL)

- 注意力机制(Attention Mechanism)

https://chatgpt.com/share/67a7ee4e-d198-8009-996d-cd7cb5e11c65

协议

本作品代码部分采用 Apache 2.0协议 进行许可。遵循许可的前提下,你可以自由地对代码进行修改,再发布,可以将代码用作商业用途。但要求你:

- 署名:在原有代码和衍生代码中,保留原作者署名及代码来源信息。

- 保留许可证:在原有代码和衍生代码中,保留Apache 2.0协议文件。

- 署名:应在使用本文档的全部或部分内容时候,注明原作者及来源信息。

- 非商业性使用:不得用于商业出版或其他任何带有商业性质的行为。如需商业使用,请联系作者。

- 相同方式共享的条件:在本文档基础上演绎、修改的作品,应当继续以知识共享署名 4.0国际许可协议进行许可。